Daten sind Gold – warum eigentlich? Weil sie viel zu „erzählen“ haben. Das gilt auch im industriellen Umfeld und dort insbesondere für Maschinen. TwinCAT Analytics hilft dabei die Maschinen-, Produktions- und Bedienparameter auszuwerten und zu interpretieren, um Mehrwerte für Maschinenbauer, Systemintegratoren, Produzenten und Endverbraucher zu generieren. Sie alle können aufgrund von verbessertem Support, neuen Geschäftsmodellen, besserer Qualität oder günstigeren Produkten profitieren.

Für die jeweiligen Ziele müssen die nützlichen Daten von den weniger nützlichen getrennt und einer zielführenden Algorithmik zugeführt werden. Die Interpretation der Daten ist dabei die schwierigste Disziplin. Die Produktfamilie TwinCAT Analytics beschreibt hierfür einen vollständigen Workflow für die Analyse von Maschinendaten: von der Daten-Akquisition über die Kommunikation und das Historisieren von Daten bis hin zu deren Sichtung und Auswertung sowie Darstellung in webbasierten Dashboards.

Das Kernstück ist sicherlich das Sichten und Auswerten der Daten. Schnelle Ladezeiten und Vertrauen in die Richtigkeit der Analyse sind sehr wichtig, wobei Transparenz eine große Rolle spielt. Diese wird durch die TwinCAT Analytics Engineering Tools erreicht, bei denen ein Konfigurationseditor für die zahlreichen Algorithmen sowie das Charting-Tool TwinCAT Scope zur grafischen Darstellung zur Verfügung stehen. Durch sehr viele Interaktionsmöglichkeiten zwischen Algorithmen und grafischer Darstellung von Roh- und Ergebnisdaten kann sehr schnell die sprichwörtliche Nadel im Datenhaufen gefunden werden. Besonders vorteilhaft ist die automatisch auf Knopfdruck erzeugte TwinCAT-Scope-Konfiguration. Mit einfachen Drag-and-Drop-Aktionen lassen sich Ergebnisse aus der Analyse in TwinCAT Scope View ziehen, um Resultate zu visualisieren oder signifikante Events im Datenstrom zu markieren. Beispielsweise werden Maschinentakte bis auf die Mikrosekunde genau sichtbar.

Daten in die Spur gebracht

Die hohe, mit TwinCAT Analytics mögliche Datenauflösung ist aber nicht immer erforderlich – insbesondere, wenn es nach einer längeren Messkampagne, z. B. über mehrere Tage hinweg, zunächst um eine Übersicht der Messwerte geht und die schnell sehr langen Ladezeiten vermieden werden sollen. In der Analyse selbst kann es durchaus auf jeden einzelnen Zyklus der Maschine ankommen, für die grobe Beurteilung der Messung ist diese Auflösung aber noch nicht erforderlich. Auch muss nicht jeder Messwert, z. B. während wenig aussagekräftiger Stillstandzeiten, zwingend in eine Analyse mit einfließen.

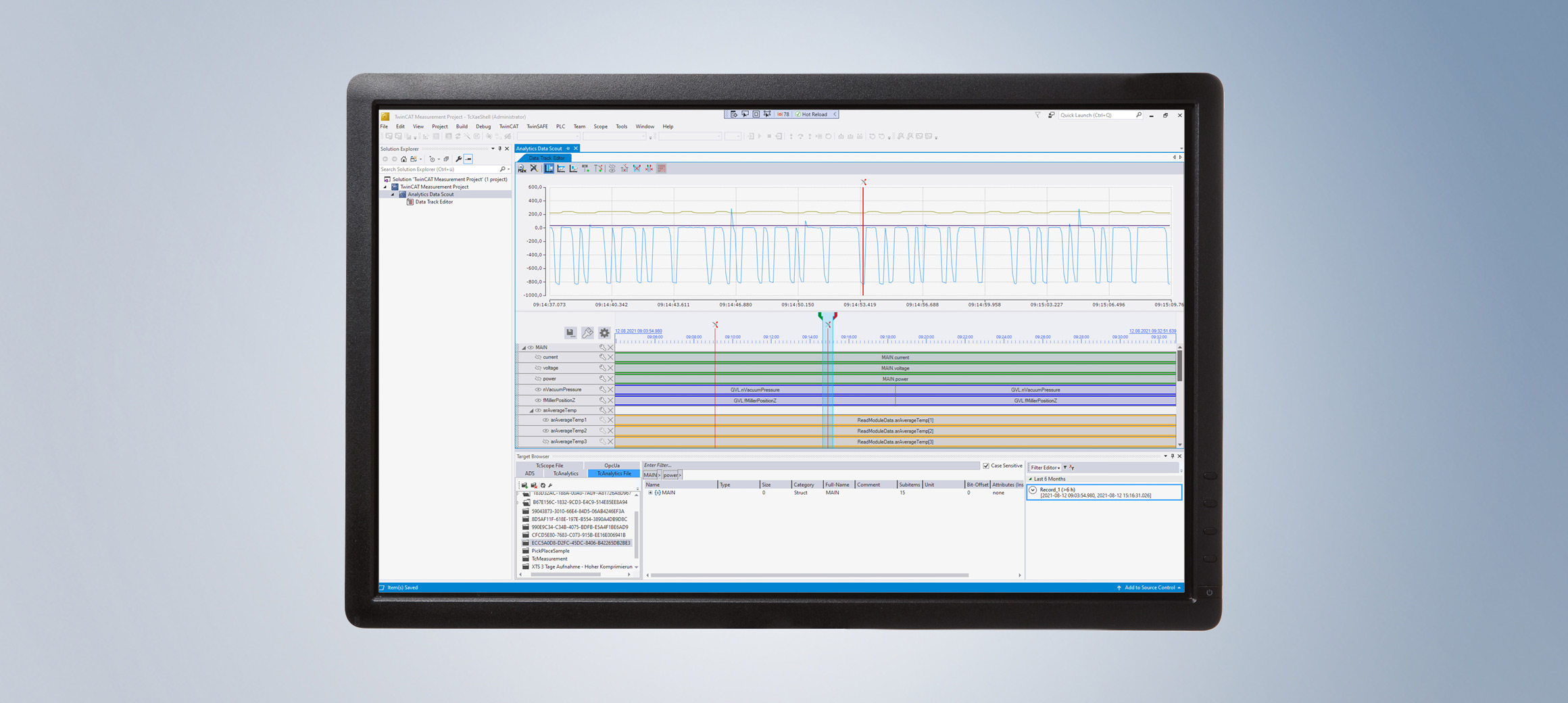

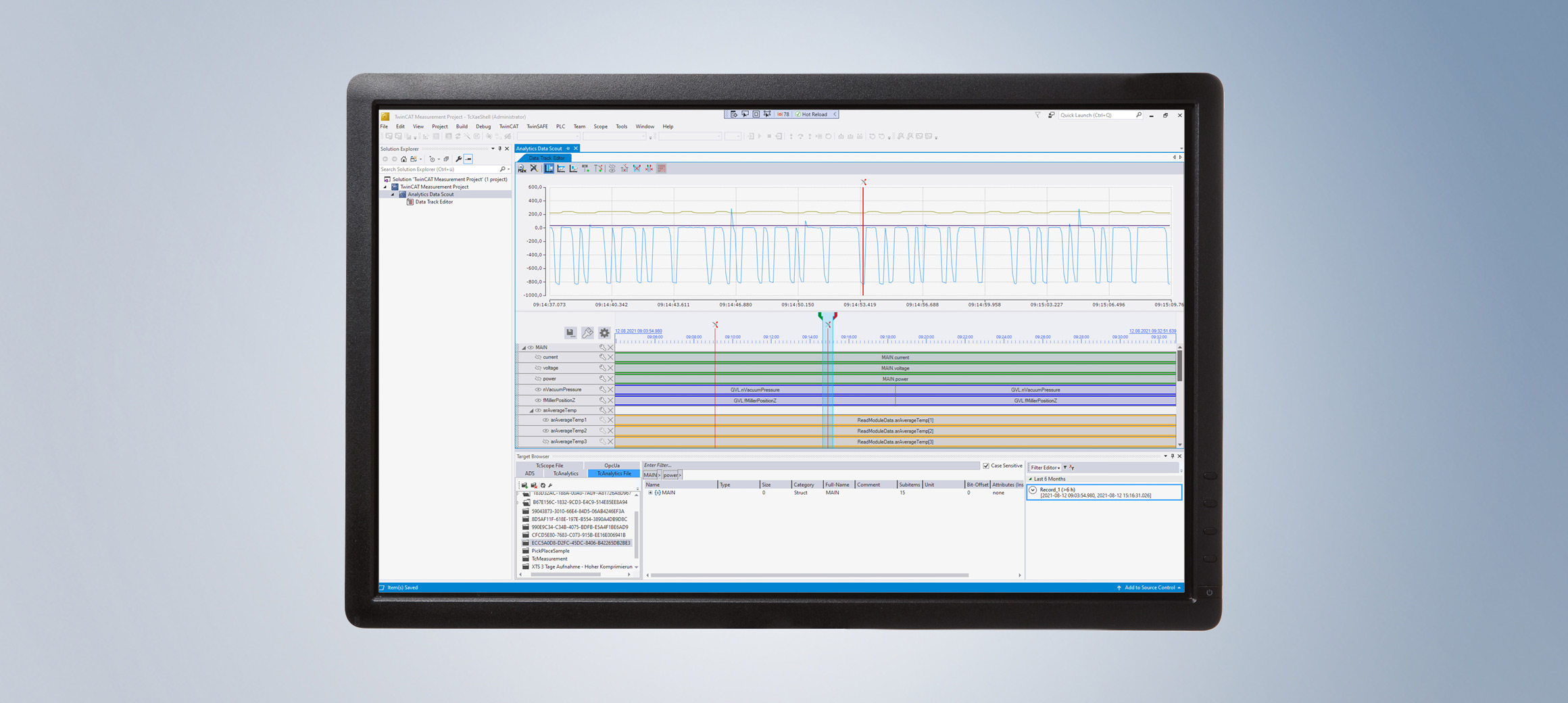

Um diesem Aspekt des Datensichtens eine größere Rolle zukommen zu lassen, wurde der TwinCAT Analytics Workflow durch den TwinCAT Analytics Data Scout ergänzt. Integriert im bekannten TwinCAT-Measurement-Projekt in Microsoft Visual Studio® bietet er einen Data Track Editor an. Dieser eignet sich optimal für eine schnelle Übersicht einzelner Datenaufnahmen, er kann direkt aus dem TwinCAT Target Browser heraus mit Daten gefüttert werden. Durch neue Datenkomprimierungs- und Datenindizierungsverfahren ist es möglich – abhängig von der Prozessabbildgröße – die Daten sehr schnell in verschiedenen Detailstufen zu laden. Die Variablen der Aufnahmen stehen dabei als sogenannte Datenspuren (Tracks) zur Verfügung. Mit der Cutting-Funktion ist es sogar möglich, große Teile der Datenaufnahme im Data Track Editor auszuschneiden, um dadurch die Analysezeit weiter zu verringern. Für die Orientierung in den einzelnen Data Tracks hilft ein Overview-Chart auf Basis von TwinCAT Scope View. Es lassen sich zudem Daten von unterschiedlichen Aufnahmen zu einem Datenstrom verbinden. Die Datentypen einzelner Tracks können dabei konvertiert werden, um je nach tatsächlichem Wertebereich Speicherplatz für die neu entstehende Datenaufnahme zu sparen. Am Ende sorgt ein Datenexport für die neue Aufnahme, die über den Target Browser anderen Tools wie Scope View oder Analytics Service Tool bereitgestellt werden kann.

Über 50 Analyse-Algorithmen

Nach dem ersten Sichten der Daten folgt die Analyse. In TwinCAT Analytics gibt es dafür mit weit über 50 Algorithmen eine sehr große Bandbreite, die von einfachen Flanken-Zählern und Taktzeitanalysen bis hin zu Korrelationsalgorithmen, linearer Regression und Unsupervised-Clustering-Verfahren reicht. Die über den Analytics Storage Provider (TF3520) historisierten Maschinendaten können sehr performant diesen einfach neu konfigurierbaren Algorithmen immer wieder zur Verfügung gestellt werden. Damit ist es möglich, spezielle Features aus den Eingangsdaten zu generieren – beispielsweise für die Anwendung von ML-basierten Methoden – und diese anschließend wieder zu laden und weiterzuverarbeiten. Neue Ideen lassen sich sehr schnell auf den bestehenden Daten testen, bevor man mit der Analytics Workbench (TE3500) eine kontinuierliche Datenüberwachung der Maschinen samt Analytics Web-Dashboard automatisch generiert und auf ein Target mit Analytics Runtime (TF3550) herunterlädt.

Sollte die Vielzahl an Algorithmen für die gewünschte Applikation dennoch nicht ausreichen, gibt es verschiedene Erweiterungsmöglichkeiten. Zum einen können andere TwinCAT-SPS-Bibliotheken mit mathematischen Algorithmen, z. B. die Filter- und Condition-Monitoring-Bibliothek, direkt in den Analytics Engineering Tools verwendet werden. Zum anderen besteht die Möglichkeit, die Algorithmik programmatisch durch die neuen Analytics-Lambda-Funktionen zu erweitern. Lambda-Funktionen werden in C++ geschrieben und können so anwenderspezifische Algorithmen zur Verfügung stellen. Bei der Implementierung wird der Anwender komplett durch einen Wizard unterstützt. Vom Anlegen der Grundstruktur mit Ein-, Ausgängen und Parametern über die Programmierung selbst bis hin zur Freigabe des Algorithmus, sodass dieser in der Algorithmen-Toolbox für alle weiteren Analytics-Projekte verfügbar ist. Die selbst entwickelte Lambda-Funktion kann mit Standard-Algorithmen als Kette verknüpft sein und mit der Workbench lässt sich eines der vorhandenen Analytics HMI Controls oder ein komplett selbst in JavaScript oder TypeScript geschriebenes Control mappen. Kommt die SPS-Code- und Dashboard-Generierung zum Einsatz wird für die Lambda-Funktion SPS-Code und das ausgewählte HMI Control generiert. Gleiches gilt für die zukünftige Integration von MATLAB®- und Simulink®-Algorithmen. Die Integration in TwinCAT Analytics erfolgt über die bestehenden Produkte TE1400 und TE1401.